ML 환경을 구축 하기 위해서는

python 개발 환경과 jupyter (anaconda)

tensorflow 설치와 gpu lib 설치 (cuda + cudnn) 등의 구축이 필요하다

또한 그것을 돌리기 위한 gpu 와 linux 서버 또는 window 개발 환경이 필요한데,

나는 근무환경상 데스크탑 구입이 어려워, 노트북 + egpu 환경으로 구성하였다.

많은 글들을 찾아보아야 했지만 정확히 어떤식으로 환경을 구성하면 된다! 라는 명확한 답이 없었다.

나의 목표는 구매 되는 비용을 최소화 + 노트북 환경으로 구축

1. egpu 환경을 구축 하기 위해서는 노트북의 썬더볼트 지원 이 중요 했고 아래 리스트에서 노트북을 고를 필요가있다.

https://www.ultrabookreview.com/10579-laptops-thunderbolt-3/

The complete list of portable laptops with a Thunderbolt 3 port

We've seen Thunderbolt ports on enthusiast computers for a while now, but these days Thunderbolt is becoming the port everyone wants on a new laptop,

www.ultrabookreview.com

이때 같은 thunderbolt3 의 경우에도 2 lane 과 4 lane 의 bandwidth 차이로 인하여 1.5배정도 성능차이가 나오게되고

이것은 고유 gpu 의 성능을 다끌어 오지 못하는 것을 의미한다.

데스크탑(노트북) + 직접연결된 gpu 6042.68 mib/s >> 4-lane tb3 2431.87 mib/s > 2-lane tb3 1597.91 mib/s

으로 성능 차이가 나온다.

나의경우에는 thunder bolt3 4lane 슬롯 2개를 지원하는 lennova yoga 730 모델을 선택 하였다.

2. egpu 를 구성하기 위해서는 gpu 를 담고 power 를 공급하는 egpu box 가 필요했다.

https://egpu.io/external-gpu-buyers-guide-2019/

Best eGPU Enclosures Reviewed - External GPU Buyer's Guide 2019

Find the best eGPU enclosures using our daily updated Buyer's Guide. We provide hands-on unboxing and in-depth review of the top external GPU enclosures.

egpu.io

여기에서 각각 지원하는 gpu 모델등과 성능 등이 있는데 . 모두 직접 수입해야 되는 리스크가 있었다.

이 중에 한성컴퓨터에서 수입 해주는 akito node pro model AS 측면에서 유리할 것 같아, 이 모델로 구입을 하였다.

각 gpu box 별로 지원하는 gpu 들은 제조사 홈페이지에 정확 히 명시 되어있다.

egpu 를 썼을 때 좋은 점은 gpu- box 에서 지원 하는 리스트로 gpu 모델을 계속 업그레이드 할 수 있다는점

단점은 장기적으로 호환성이 떨어 질 수 있으며, 직접연결보다 성능이 저하 될 수 있다는 점이다.

그밖에 휴대성이나

대략 egpu box - 40만원 yoga730 - 100만원 중고 gtx 1060(6GB) -15만원 정도 비용이 소모되었다.

3. 그래픽 Nvida 드라이버와 cuda / cudnn 라이브러리 설치 삽질기

cuda + cudnn 의 환경을 설치하는 사람이 전세계적으로 몇십만명은 될텐데

미묘한 버그가있다.

물론 window10 에서 개발하기떄문에 생기는 문제이지만..

tensorflow 1.13 의 경우 cuda 10.0 과 cudnn 7.5 으로 맞춰주지 않으면 no lib 에러가난다.

tensorflow 1.12 의 경우 cuda 9.0 과 cudnn 7.5 로 맞춰주지 않으면 호환이 안된다.

공식홈페이지의 경우 어떤 버전을 설치해도 지원이 된다는 식으로 나와있는데.

실제 설치해보면 라이브러리를 못불러오는 세새한 문제가 있다.

이러한 문제들은 버전 업되면서 해결될 것으로 보이지만, 개발 되는 버전에 따라서 호환성에 문제가 있는듯 하다.

'Machine.Learning' 카테고리의 다른 글

| rtx 3080 - ubuntu 20.04 개발환경 설치기 (0) | 2021.01.22 |

|---|---|

| 머신러닝 족보 ! scikit learn algorithm cheat sheet (0) | 2019.09.04 |

| machine Learning Automation (0) | 2019.04.08 |

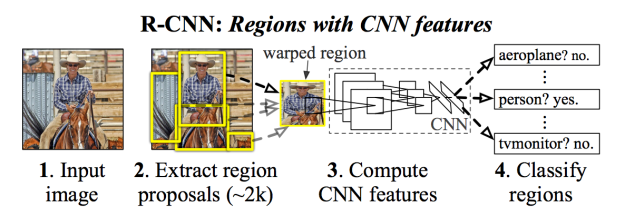

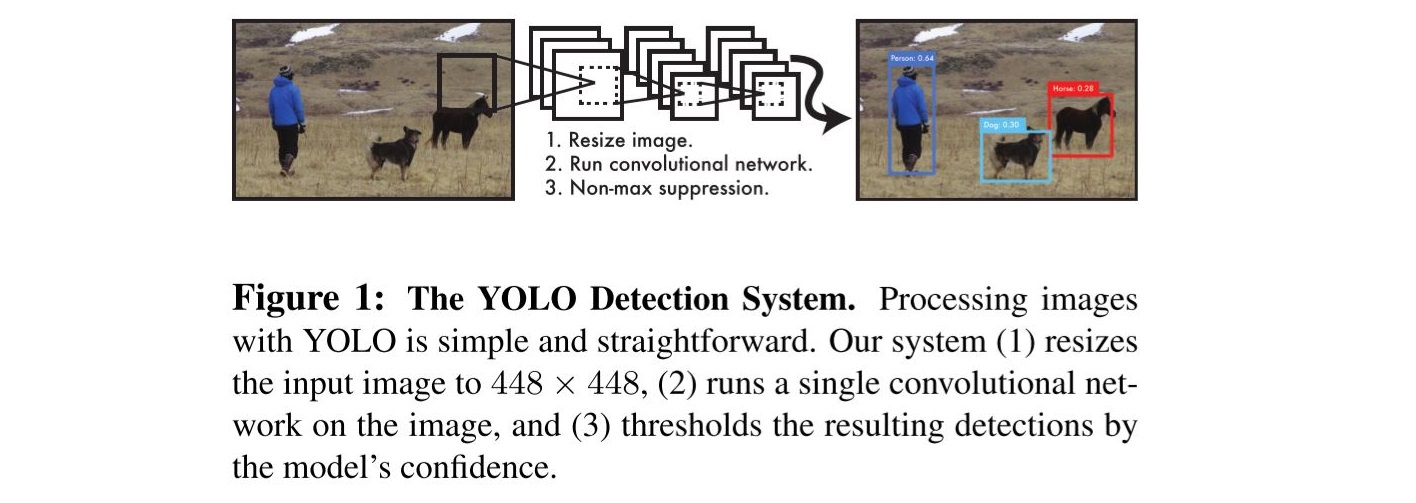

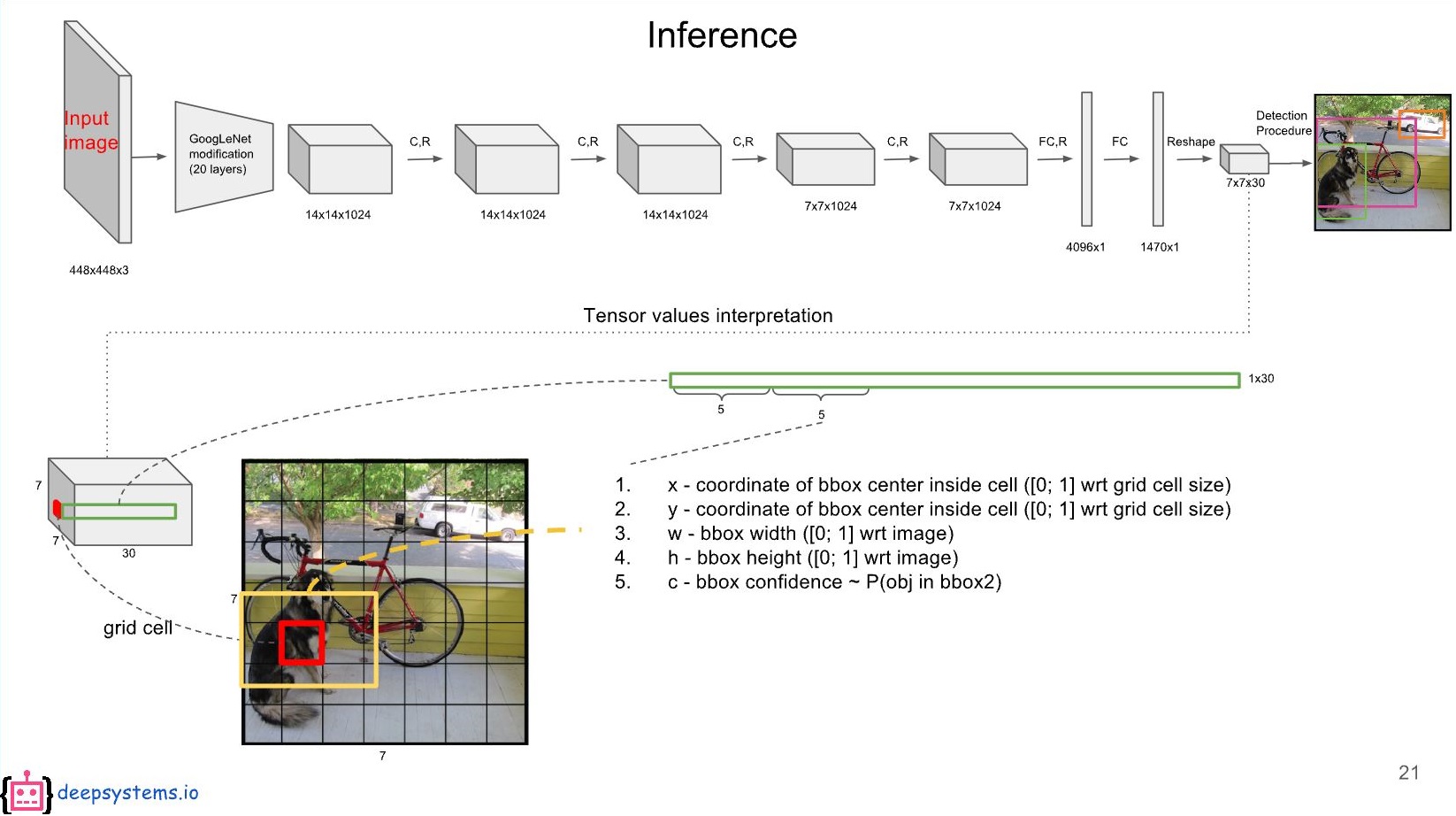

| fast cnns (yolo, R-CNN, SSD) (0) | 2019.02.12 |

| tensorframes (0) | 2018.11.20 |